在数字化转型的浪潮下,企业对数据处理与分析的实时性需求日益增强。构建高效的pg国际流式ETL系统成为了一种必然选择,以满足现代商业环境中快速反应市场变化的需求。本文将详细探讨如何通过这一系统实现数据实时处理与分析,并从多个方面进行深入分析,包括技术架构、数据采集、数据转换及应用场景等四个方面。通过这些讨论,我们希望为企业提供一个全面而新颖的数据解决方案,为其决策支持与业务优化提供有力保障。

1、技术架构设计

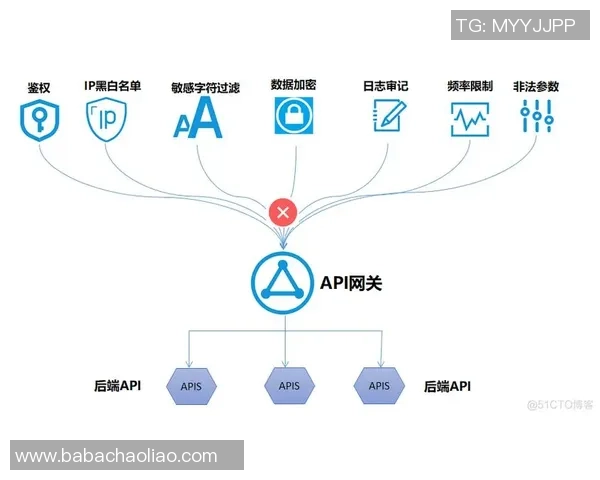

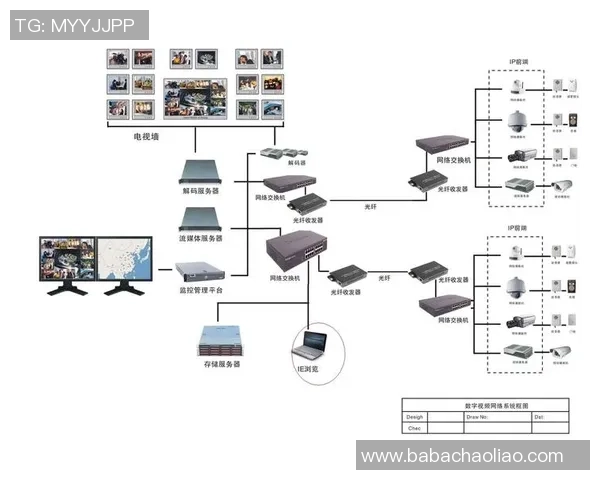

高效的pg国际流式ETL系统首先需要一个合理且灵活的技术架构。该架构通常由数据源层、处理层和存储层组成,各层之间通过高效的数据传输机制连接,实现数据在不同环节间的快速流动。在此基础上,采用分布式计算框架能够有效提升系统并发处理能力,从而保证在高负载情况下仍能保持良好的性能表现。

此外,微服务架构的引入,使得各组件可以独立开发和部署,这样不仅提高了系统的可扩展性,还降低了维护成本。在实际应用中,可以根据需求灵活调整各服务模块,提高整体效率。同时,通过结合容器化技术,可以简化部署流程,并提升资源利用率。

最后,在监控和日志管理方面,系统需要具备实时监控功能,以便及时发现潜在问题并进行故障排查。这一机制确保了整个ETL过程能够顺利进行,为后续的数据分析提供稳定可靠的基础。

2、数据采集策略

在pg国际流式ETL系统中,数据采集是关键的一步,其质量直接影响到后续的数据分析效果。因此,需要制定科学合理的数据采集策略。首先,应当选择合适的数据源,包括关系型数据库、NoSQL数据库以及社交媒体等多种形式,确保覆盖广泛的信息来源。

其次,在数据采集过程中,应采用增量加载方式,即仅提取自上次更新以来的新数据或变更记录,这样可以显著减少网络带宽消耗,提高采集效率。此外,对于实时性要求较高的数据,可以考虑使用消息队列等工具,实现低延迟的数据传输。

最后,在保证数据完整性的前提下,要对所采集的数据进行初步清洗和格式化。这一步骤至关重要,有助于提高后续处理环节中的效率,确保最终输出结果具有较高的准确性和可靠性。

3、数据转换流程

一旦完成数据采集,就进入了关键的数据转换环节。在这一阶段,需要对原始数据进行加工,以便其符合目标数据库或应用程序的要求。这包括字段映射、类型转换以及复杂计算等操作。设计合理且高效的转换流程,将直接影响到后续的数据存储与查询性能。

在实际操作中,可以借助开源工具如Apache NiFi或Talend来实现自动化转换,这些工具不仅支持可视化配pgvip国际置,还能通过配置规则动态调整转换逻辑。同时,通过编写自定义脚本,可以针对特定业务需求,实现更加灵活细致的处理策略。

最后,在每次转换完成后,都需建立相应的数据质量检查机制,以确保输出结果符合预期标准。这些质量检查可以包括去重、有效性验证及一致性检查等,有助于提升最终分析结果的可信度和实用性。

4、多场景应用案例

构建高效pg国际流式ETL系统,不仅是一项技术工程,更是推动业务创新的重要手段。在金融行业,该系统能够实现对交易记录的实时监控与分析,为风险控制提供依据;同时,它还能支持反欺诈模型训练,从而增强安全防护能力。

在零售行业,通过实时获取销售数据并进行分析,可以帮助商家迅速了解市场动态,优化库存管理。此外,该系统还可用于个性化营销,通过用户行为分析,为客户提供精准推荐,提高客户满意度及忠诚度。

同样,在医疗行业,高效流式ETL系统也展现出巨大的应用潜力。通过整合来自不同医院的信息,如病历记录、影像资料及检测结果等,不仅能促进科研进展,也为患者提供更优质、更及时的医疗服务奠定基础。

总结:

综上所述,构建高效的pg国际流式ETL系统为企业实现数据实时处理与分析提供了一种全新的解决方案。从技术架构设计到具体实施步骤,每一个环节都至关重要,而它们共同作用形成强大的竞争优势,使得企业能够快速响应市场变化,把握发展机遇。

未来,随着大数据技术的发展以及人工智能算法不断演进,这一系统将持续发挥其核心价值,为各行各业打通信息孤岛,实现智慧决策铺平道路。因此,各企业应积极布局相关技术,加速数字转型进程,以保持市场竞争力并推动可持续发展。